コンテンツ投稿&コンテンツマイニングイールドで収益を得よう

placeholder

Crypto24pro

⚖️ パワー、政策、市場心理が衝突する

稀な瞬間。

深刻なシグナル。

市場は注視している。 👀

🏦 フェッド議長ジェローム・パウエルはジェローム・クック最高裁判所公聴会に出席

単なる法的出席だけではなく

政策的含意に満ちた瞬間

これはノイズではない。

これは信頼感に敏感な領域だ。

📊 トーンの変化

🧠 圧力の兆候

⚡ 独立性の解釈

が世界の市場に波及する可能性がある

なぜこれが重要なのか?

🏛 中央銀行の信用はリスク志向を形成する

📉 不確実性は信頼を揺るがす

📈 明確さは資本流入を促進する

暗号通貨はこのような瞬間に素早く反応する。

透明性に繁栄し

疑念には鋭く反応する

🐋 機関投資家は行間を読む

📊 トレーダーはポジションを調整

💎 長期保有者はマクロストレスを追跡

政策はただ声明に書かれるだけではない

時には部屋の中で感じられることもある

これがフェッドの独立性を強化するのか?

それとも新たな疑問を物語に注入するのか?

ボラティリティは許可を求めない

きっかけを待つだけだ。

一つの公聴会

一つのメッセージ

潜在的に多くの市場反応

マクロインテリジェンス、政策の影響、リアルタイムの暗号洞察をフォロー 🚀

情報を得て、早めに動き、先を行け。#CryptoMarketPullback $GT $BTC $SOL

原文表示稀な瞬間。

深刻なシグナル。

市場は注視している。 👀

🏦 フェッド議長ジェローム・パウエルはジェローム・クック最高裁判所公聴会に出席

単なる法的出席だけではなく

政策的含意に満ちた瞬間

これはノイズではない。

これは信頼感に敏感な領域だ。

📊 トーンの変化

🧠 圧力の兆候

⚡ 独立性の解釈

が世界の市場に波及する可能性がある

なぜこれが重要なのか?

🏛 中央銀行の信用はリスク志向を形成する

📉 不確実性は信頼を揺るがす

📈 明確さは資本流入を促進する

暗号通貨はこのような瞬間に素早く反応する。

透明性に繁栄し

疑念には鋭く反応する

🐋 機関投資家は行間を読む

📊 トレーダーはポジションを調整

💎 長期保有者はマクロストレスを追跡

政策はただ声明に書かれるだけではない

時には部屋の中で感じられることもある

これがフェッドの独立性を強化するのか?

それとも新たな疑問を物語に注入するのか?

ボラティリティは許可を求めない

きっかけを待つだけだ。

一つの公聴会

一つのメッセージ

潜在的に多くの市場反応

マクロインテリジェンス、政策の影響、リアルタイムの暗号洞察をフォロー 🚀

情報を得て、早めに動き、先を行け。#CryptoMarketPullback $GT $BTC $SOL

- 報酬

- いいね

- コメント

- リポスト

- 共有

- 報酬

- いいね

- 1

- リポスト

- 共有

GateUser-02b5f211 :

:

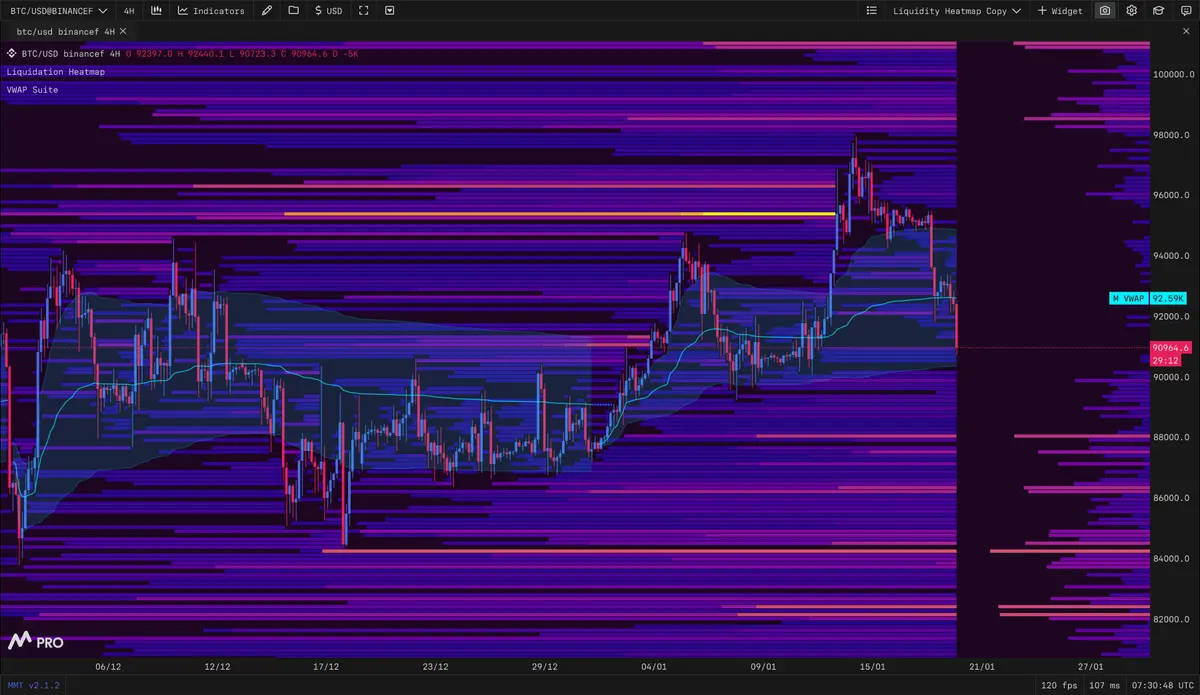

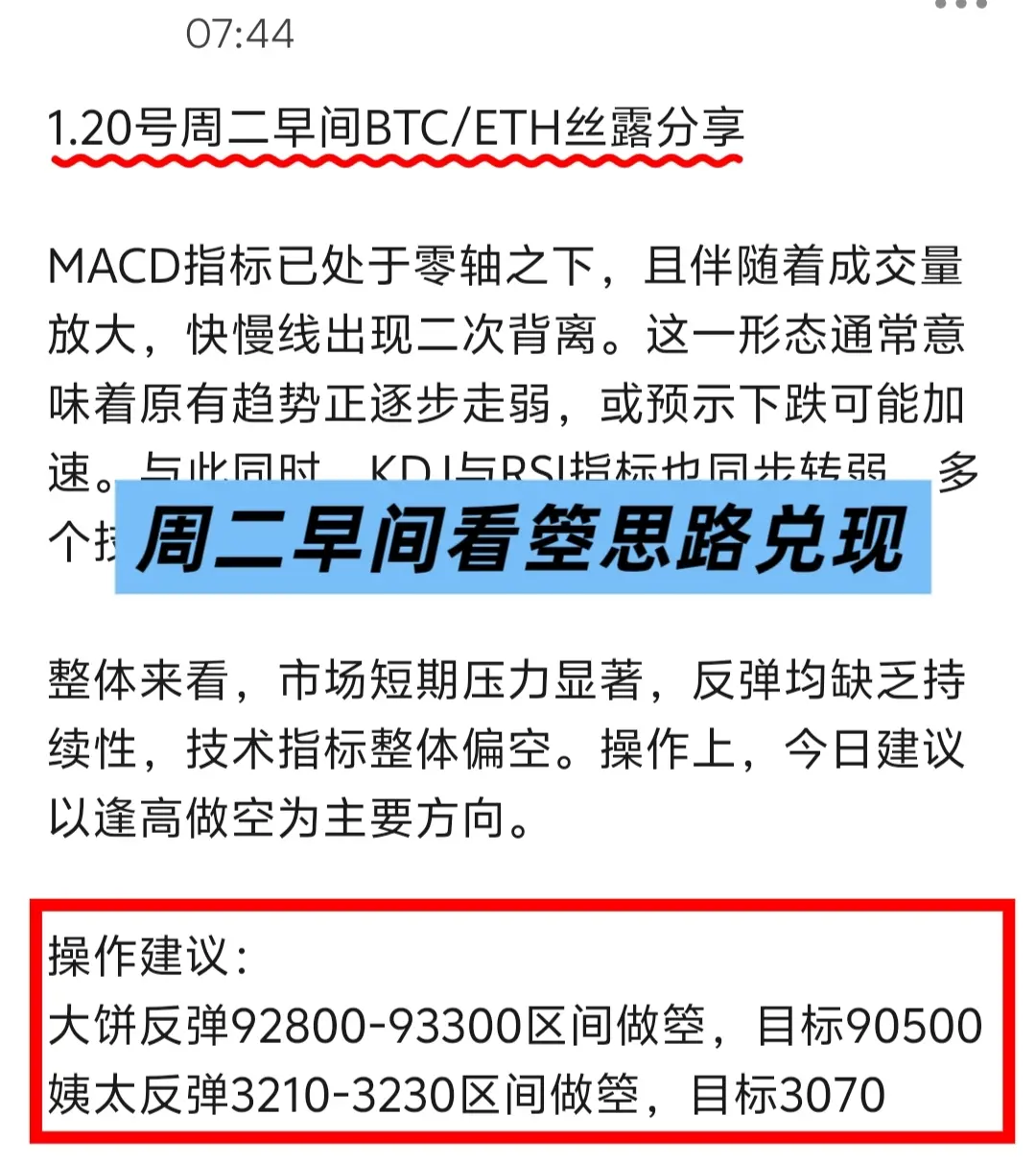

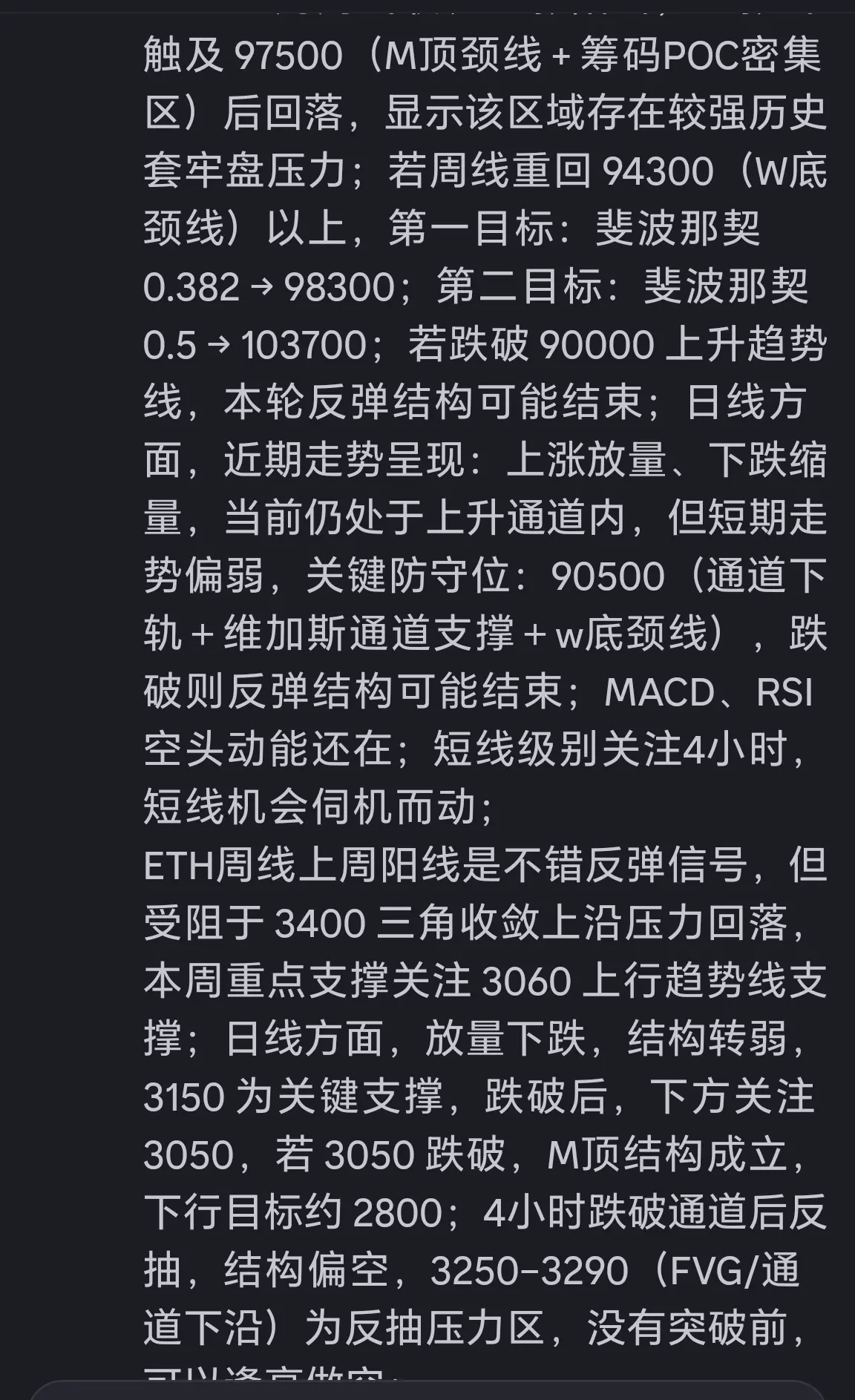

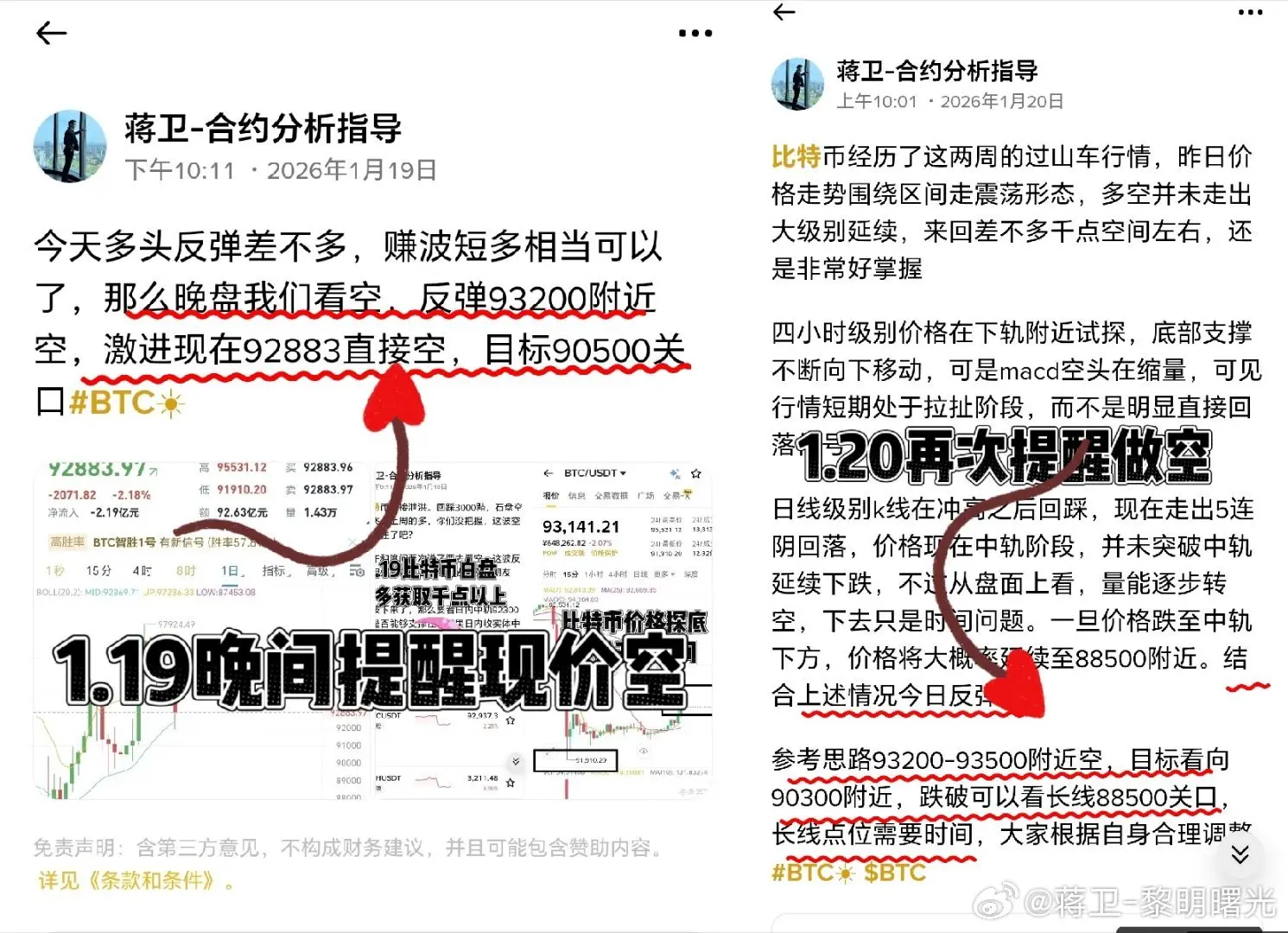

大饼短期四時間はレンジ修正を示し、箜頭の勢いは弱まっているが、哆頭はまだ主導していない。 MACDのデッドクロス状態で、緑柱は徐々に縮小しており、箜頭の勢いは弱まっているが完全に消失していない。低位でのゴールデンクロスが初めて現れ、J線は上向きに折れ曲がっており、反発の勢いはあるが動きの勢いは不足している。

箜策略:92000の抵抗を受けて軽めの空売りを試み、ストップロスは92800以上に設定、ターゲットは88000、下抜けた場合は86000を見込む #BTC

- 報酬

- いいね

- コメント

- リポスト

- 共有

Elon Musk

Elon Musk

作成者@CryptoGongjin

申込状況

0.00%

時価総額:

$0

自分のトークンを作成

#欧美关税风波冲击市场 先明确核心結論:GAT(グラフ注意力ネットワーク)はGNNの重要な分野であり、核心は注意力メカニズムを利用して隣接ノードの重みを動的に割り当てることで、GCNなどの固定重みの制約を解決し、自適応性、並列処理、解釈性を兼ね備え、異質/動的グラフやノード分類などのタスクに適している。ただし、計算コストや過学習のリスクも存在する。以下、原理、長所と短所、応用例と実践ポイントについて展開する。

一、核心原理

- ノードは「どの隣接ノードにより注目すべきか」を学習し、注意重みを用いて隣接情報を加重集約し、より正確なノード表現を得る。

- 計算フロー:

1. ノード特徴を重み行列で投影し、新空間に線形変換。

2. 自注意力を用いて隣接ノード間の関連スコアを計算し、softmaxで正規化。

3. 注意重みに基づき隣接ノードの特徴を集約し、同時にノード自身の情報も保持。

4. マルチヘッド強化技術を用いて、中間層で複数のヘッド出力を結合し次元拡張、出力層で平均を取り安定性を向上。

二、核心の長所

- 自適応加重:グラフ構造に依存せず、データ駆動で重みを学習し、複雑な関係に適応。

- 高効率並列:隣接重みは独立して計算可能で、全体の隣接行列に依存しないため、大規模・動的グラフに適合。

- 解釈性:注意重みの可視化により、重要な接続や意思決定の根拠を分析しやすい

原文表示一、核心原理

- ノードは「どの隣接ノードにより注目すべきか」を学習し、注意重みを用いて隣接情報を加重集約し、より正確なノード表現を得る。

- 計算フロー:

1. ノード特徴を重み行列で投影し、新空間に線形変換。

2. 自注意力を用いて隣接ノード間の関連スコアを計算し、softmaxで正規化。

3. 注意重みに基づき隣接ノードの特徴を集約し、同時にノード自身の情報も保持。

4. マルチヘッド強化技術を用いて、中間層で複数のヘッド出力を結合し次元拡張、出力層で平均を取り安定性を向上。

二、核心の長所

- 自適応加重:グラフ構造に依存せず、データ駆動で重みを学習し、複雑な関係に適応。

- 高効率並列:隣接重みは独立して計算可能で、全体の隣接行列に依存しないため、大規模・動的グラフに適合。

- 解釈性:注意重みの可視化により、重要な接続や意思決定の根拠を分析しやすい

- 報酬

- いいね

- コメント

- リポスト

- 共有

- 報酬

- いいね

- コメント

- リポスト

- 共有

新しい友達の参加を歓迎します!砂はゴミであり、コンクリートもゴミですが、それらを混ぜるとコンクリートになり、これは高品質です。米は高品質であり、ガソリンも高品質ですが、それらを混ぜるとゴミになります。高品質かゴミかは重要ではなく、誰と混ざるかが非常に重要です!

原文表示

- 報酬

- いいね

- コメント

- リポスト

- 共有

ショートするのとコインを空にするのはどちらが良いか、もう金や銀を空にするのは怖くてできない🤪

原文表示

- 報酬

- いいね

- コメント

- リポスト

- 共有

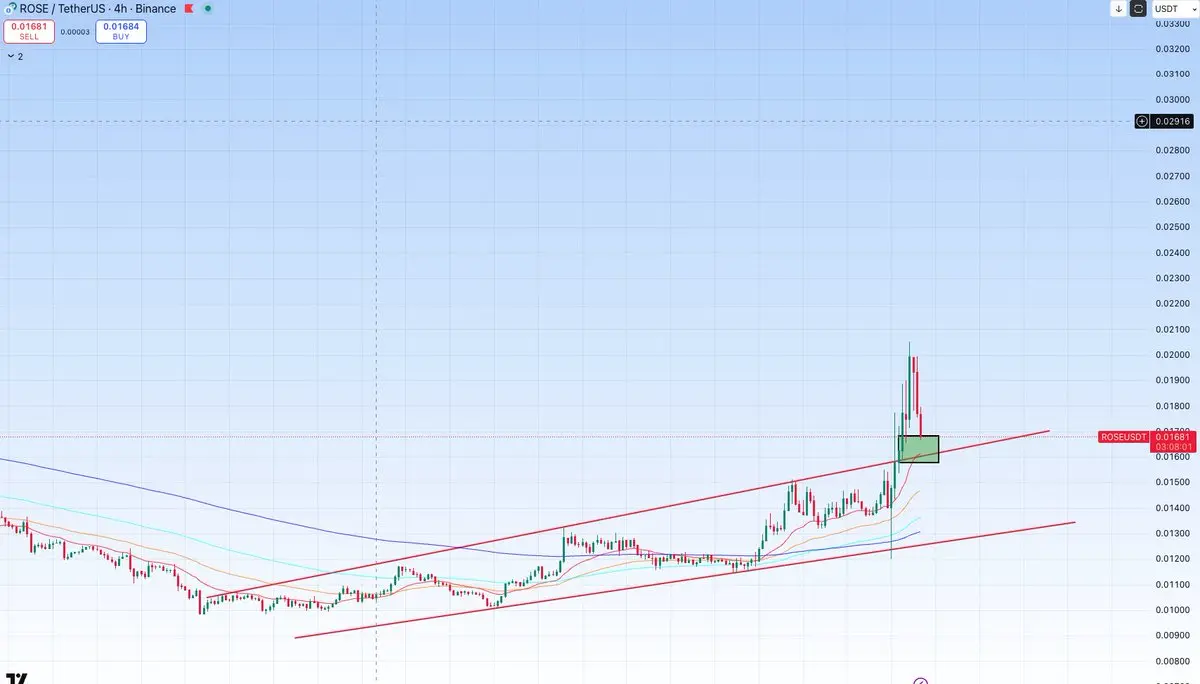

$ROSE 更新:リテストゾーンに注目

原文表示

- 報酬

- いいね

- コメント

- リポスト

- 共有

- 報酬

- いいね

- コメント

- リポスト

- 共有

Gate CrossEx アカウントが稼働中です。

プロトレーダー、機関投資家、クオンツチーム向けに設計されたCrossExは、複数の取引所の取引と清算を統合し、資本効率と実行速度を向上させます。

~ スポット、クロスマージン、USDT先物

~ 統一されたリスク管理で最大20倍のレバレッジ

~ プロフェッショナル向けのAPI専用取引

2024年1月19日 (8 UTC) – 2024年2月19日 (8 UTC)

今すぐ開設 👇

詳細はこちら 👇

原文表示プロトレーダー、機関投資家、クオンツチーム向けに設計されたCrossExは、複数の取引所の取引と清算を統合し、資本効率と実行速度を向上させます。

~ スポット、クロスマージン、USDT先物

~ 統一されたリスク管理で最大20倍のレバレッジ

~ プロフェッショナル向けのAPI専用取引

2024年1月19日 (8 UTC) – 2024年2月19日 (8 UTC)

今すぐ開設 👇

詳細はこちら 👇

- 報酬

- いいね

- コメント

- リポスト

- 共有

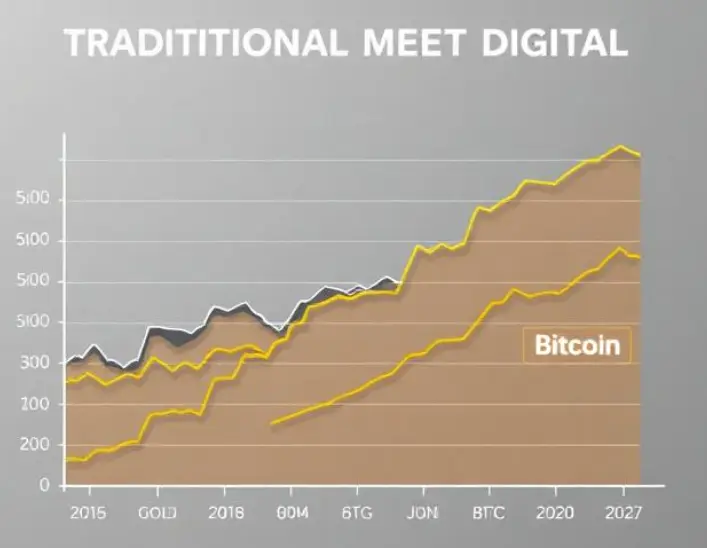

#GoldandSilverHitNewHighs

🥇 金と銀が史上最高値を更新!貴金属を追加する時ですか? 💰✨

安全資産のラリーは本物です!金と銀の両方が記録的な高値に急騰し、投資家は市場の不安定さの中で安定性を求めています。この傾向は、暗号通貨が支配的な世界にあっても、伝統的な資産がリスクヘッジのために依然として大きな魅力を持っていることを示しています。 📈

私の見解では、市場は強いシグナルを送っています:金と銀がこのように一緒に動くとき、投資家の安全資産への信頼が高まり、それはしばしばより広範なリスク志向の変化に先行します。私は個人的に、成長の可能性を保ちながらも安全性を重視して、金属に少額のポジションを検討しています。

興味深いのは、暗号通貨のセンチメントとの相関関係が現れ始めていることです。歴史的に、BTCがわずかに後退するとき、金と銀は短期的な資金流入を引き付け、バッファーとして機能します。これは数週間続く金属のラリーの始まりでしょうか?それとも、次の上昇局面の前の調整の可能性でしょうか?皆さんの意見を聞きたいです。

📊 ビジュアルアイデア:

過去3ヶ月間の金、銀、BTCの価格動向を比較したチャート。

または、Gate.ioの金属取引ダッシュボードのスクリーンショットで、最近の高値を強調したもの。

興味があります — 今、貴金属を追加していますか、それとも下

🥇 金と銀が史上最高値を更新!貴金属を追加する時ですか? 💰✨

安全資産のラリーは本物です!金と銀の両方が記録的な高値に急騰し、投資家は市場の不安定さの中で安定性を求めています。この傾向は、暗号通貨が支配的な世界にあっても、伝統的な資産がリスクヘッジのために依然として大きな魅力を持っていることを示しています。 📈

私の見解では、市場は強いシグナルを送っています:金と銀がこのように一緒に動くとき、投資家の安全資産への信頼が高まり、それはしばしばより広範なリスク志向の変化に先行します。私は個人的に、成長の可能性を保ちながらも安全性を重視して、金属に少額のポジションを検討しています。

興味深いのは、暗号通貨のセンチメントとの相関関係が現れ始めていることです。歴史的に、BTCがわずかに後退するとき、金と銀は短期的な資金流入を引き付け、バッファーとして機能します。これは数週間続く金属のラリーの始まりでしょうか?それとも、次の上昇局面の前の調整の可能性でしょうか?皆さんの意見を聞きたいです。

📊 ビジュアルアイデア:

過去3ヶ月間の金、銀、BTCの価格動向を比較したチャート。

または、Gate.ioの金属取引ダッシュボードのスクリーンショットで、最近の高値を強調したもの。

興味があります — 今、貴金属を追加していますか、それとも下

BTC-2.26%

- 報酬

- 2

- コメント

- リポスト

- 共有

HIX

HIVAX

作成者@heyivax

上場の進行状況

0.00%

時価総額:

$3.46K

自分のトークンを作成

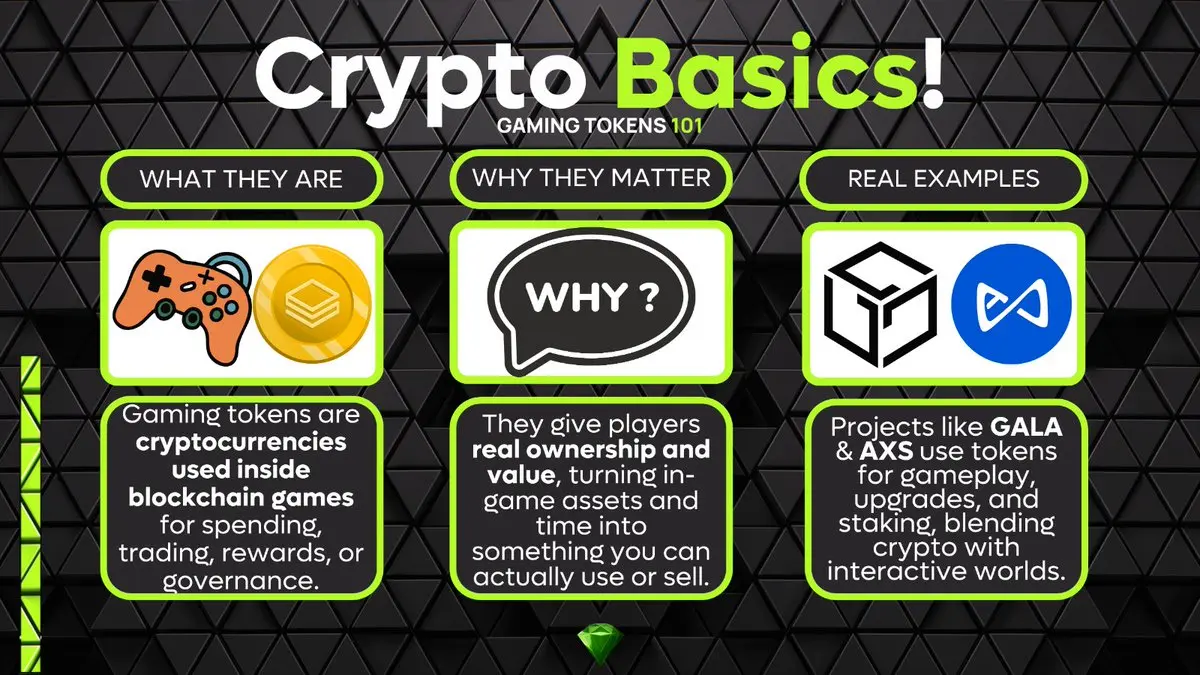

もう一つのCrypto Basicsの時間です。あなたはCryptoゲームをプレイしますか?もしそうなら、きっとGamingトークンを見たことがあるでしょう。

これを友達に送って、Play to Earnのやり方を学んでもらいましょう!

原文表示これを友達に送って、Play to Earnのやり方を学んでもらいましょう!

- 報酬

- いいね

- コメント

- リポスト

- 共有

準備を整えておけば、慌てる必要がありません

ロックイン済み

原文表示ロックイン済み

- 報酬

- いいね

- コメント

- リポスト

- 共有

- 報酬

- いいね

- コメント

- リポスト

- 共有

私たちはGatelayerネットワークで最高のプロジェクトになります。現在2位です。トップに立ったとき、すべての注目は私たちに集まるでしょう。TNEWSはすべてのネットワークで発展し、成長しています...

#CryptoMarketPullback #GateLayer #GateLayer正式上線

原文表示#CryptoMarketPullback #GateLayer #GateLayer正式上線

時価総額:$202.7K保有者数:172

100.00%

- 報酬

- 1

- コメント

- リポスト

- 共有

おはようございます、男子と女子の皆さん。

利益を出す時間です。

原文表示利益を出す時間です。

- 報酬

- いいね

- コメント

- リポスト

- 共有

少しだけ取引をした昨日、一つの小さなロングポジションを閉じることができ、早すぎるエントリーによる清算を捕らえました。

原文表示- 報酬

- いいね

- 1

- リポスト

- 共有

Bratzdnipra :

:

現在、上昇を待っていますもっと詳しく